写在前面

在kubernetes集群中运维生成环境的服务已经长达半年多时间,我们遇到了很多问题,也踩到了很多坑,其中因为 Docker Registry 的故障而导致的不可用事件还是挺多的,这些问题常常被用户埋怨。

Docker Registry 作为镜像仓库、数据中心,在整个服务发布流程中是异常关键的一环。由于之前初期我们搭建的 Docker Registry 是通过 docker run 跑在单机的方式,这种情况下不仅有单点问题,还面临着磁盘损坏和镜像丢失的危险性。

后来为了提高平台的稳定性和可靠性,也为了我的毕业论文,特地的花时间来调研 Docker Registry 的部署和设计方案,这个方案不仅采纳了开源社区和其他公司的部署策略,同时也结合了本公司内部的基础上而设计的一套高可用的 Docker Registry 方案。

调研初期

在2017年3月份时候有幸参加了 ebay 公司举办了亿贝TechDay活动,在这次公开技术分享中,我不仅见识了由DaoCloud技术合伙人孙宏亮大神所分享的Docker安全思考,也同时领略了其他公司关于kubernetes、关于docker、关于registry的思考和尝试。

携程、京东的 Docker Registry 的部署过程中,都用到了一个harbor的开源镜像管理软件,这是我第一次接触这个项目。后面我们的 Docker Registry 部署方案的设计中也同时采用了 harbor 这个开源项目。

Docker Registry 的后端存储

在 harbor 这个开源项目中,默认的 registry 是以 replication controller 的形式部署在 kubernetes 上的,采用 persistent volume 作为 registry 的后端存储。存在的问题是:即使增大 registry 的副本数,这些 registry 后端存储的仍是同一个本地的文件路径 “host path”,这种形式下仍旧存在单点问题,造成镜像文件的丢失。

所以目前存在的问题是多个 Docker Registry 如何共享后端存储?网上的实现方式有很多,比如 NFS、GlusterFS、CephFS 等。相对于使用这些分布式系统,我们内部有现成的一套 HDFS 分布式文件系统,但有个问题是 kubernetes 本身是不支持 HDFS 文件系统作为它内部的 volume 的,这就造成了如何在 kubernetes 部署 Docker Registry 集群造成一定的困难。

变通与使用 HDFS

我们的办法是使用 kubernetes 内部支持的 host path 的形式作为每个 registry 的后端存储,最关键的一步是将这些 host path 全部挂载到 HDFS 的同一个目录,这样就可以实现多个 registry 共享同一套后端存储,既解决了 registry 的单点问题,又保证了镜像仓库的可靠性。

挂载 HDFS 的目录

我们先选好三台机器作为 Docker Registry 的部署机器,分别打上标签

1 | kubectl label node node1.X.com registry=true |

其次分别登录到这些机器上,建立一个目录作为 registry 的存储位置

1 | mkdir -p /home/work/hdfs/docker/images |

然后把这个目录挂载到预先建立好的同一个HDFS目录上,挂载方式是通过执行 hadoop client 里的挂载脚本,过程如下

1 | local_dir=/home/work/hdfs/docker/images |

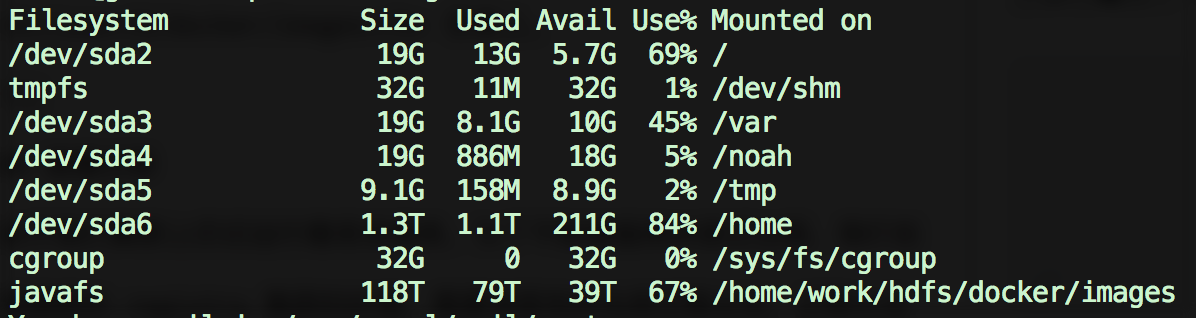

最后的效果就是这三个节点的 /home/work/hdfs/docker/images 路径全部挂载到了 HDFS 的 /user/X/docker/images 目录上。

镜像迁移

由于我们集群上仍旧运行着很多服务,为了不影响服务的变迁过程,我们在搭建新的 registry 集群的时候,需要将原有的仓库迁移过去。迁移办法很简单,通过脚本方式完成,缺点是比较耗时:

1 | import os |

注意 target_registry = '10.254.60.41:5000' 是 kubernetes 临时搭建的镜像仓库地址,不过后端存储使用的是 HDFS 上的镜像仓库目录 /user/X/docker/images

kubernetes 上部署

在 kubernetes 上拉起三个 registry 集群的配置文件: Config Map 的配置文件 registry.cm.yaml 内容如下

1 | apiVersion: v1 |

Replication Controller 配置文件 registry.rc.yaml 内容如下

1 | apiVersion: v1 |

然后创建 registry 集群

1 | # kubectl create -f registry.cm.yaml |

Registry 镜像仓库的负载均衡

kubernetes 上我们已经搭建了三个 registry 实例,它们共享同一套后端存储,统一把镜像文件存储到 HDFS 集群上,这样保障了镜像仓库的可靠性。为了用户更好的使用这些 registry,还需要为这三个 registry 增加一个负载均衡器。

本文三个 registry 部署的情况如下:

1 | hostA:8989 |

可以选用 nginx + keepalived 实现高可用的负载均衡器,不过为了安全起见,我们是在公司内部申请了一个虚拟的 VIP 来映射三个 registry 的部署端口,从而实现负载均衡的功能。

最后

经过这次成本很低的简易改造,大大的提高了 registry 镜像仓库的可靠性和稳定性。